- Författare Lynn Donovan [email protected].

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

Dataintag är processen att erhålla och importera data för omedelbar användning eller lagring i en databas. Att få i sig något är att "ta i något eller ta till sig något". Data kan streamas i realtid eller intas i omgångar.

Vet också, vad är dataintagspipeline?

Dataintagspipeline . A pipeline för dataintag flyttar streaming data och batchad data från redan existerande databaser och data lager till en data sjö. För en HDFS-baserad data sjö, verktyg som Kafka, Hive eller Spark används för dataintag . Kafka är en populär dataintag verktyg som stöder streaming data.

Dessutom, hur får Hadoop in data? Hadoop använder ett distribuerat filsystem som är optimerat för läsning och skrivning av stora filer. När man skriver till HDFS , data "skivas" och replikeras över servrarna i en Hadoop klunga. Skivningsprocessen skapar många små underenheter (block) av den större filen och skriver dem transparent till klusternoderna.

För det andra, vad är verktyg för dataintag?

Datainmatningsverktyg tillhandahålla ett ramverk som tillåter företag att samla in, importera, ladda, överföra, integrera och bearbeta data från ett brett utbud av data källor. De underlättar data utvinningsprocessen genom att stödja olika data transportprotokoll.

Vad är din förståelse för dataintag och integration?

Dataintag är de processen av inta data från ett system till ett annat. Dataintegration tillåter olika data typer (som data uppsättningar, dokument och tabeller) som ska slås samman och användas av applikationer för personliga eller affärsprocesser.

Rekommenderad:

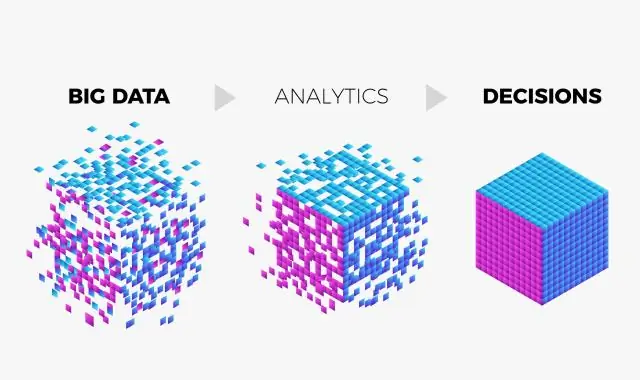

Vad är ett big data-system?

Ett big data-system består av de obligatoriska funktionerna data, datalagring, informationshantering, dataanalys, databehandling, gränssnitt och visualisering, och den valfria funktionen, System Orchestrator

Vad gör Google med big data?

Svaret är Big data analytics. Google använder Big Data-verktyg och tekniker för att förstå våra krav baserat på flera parametrar som sökhistorik, platser, trender etc

Vad är Impala i big data?

Impala är en frågemotor för massiv parallell bearbetning med öppen källkod ovanpå klustrade system som Apache Hadoop. Den skapades baserat på Googles Dremel-papper. Det är en interaktiv SQL-liknande frågemotor som körs ovanpå Hadoop Distributed File System (HDFS). Impala använder HDFS som sin underliggande lagring

Vad är V:n för big data?

I de flesta stora datakretsar kallas dessa de fyra V:en: volym, variation, hastighet och sanningsenlighet. (Du kan överväga ett femte V-värde.)

Vad är use case i big data?

Även om majoriteten av fallen för användning av big data handlar om datalagring och bearbetning, täcker de flera affärsaspekter, såsom kundanalys, riskbedömning och bedrägeriupptäckt. Så varje företag kan hitta det relevanta användningsfallet för att tillfredsställa deras specifika behov