- Författare Lynn Donovan [email protected].

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

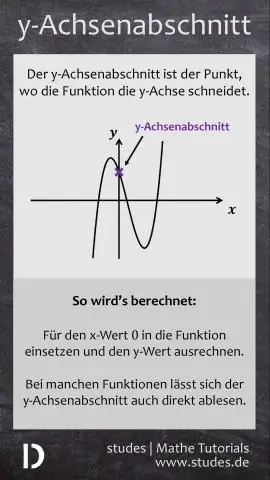

Regularisering . Detta är en form av regression , som begränsar/regulariserar eller krymper koefficientuppskattningarna mot noll. Med andra ord, denna teknik motverkar att lära sig en mer komplex eller flexibel modell , för att undvika risken för övermontering. Ett enkelt förhållande till linjär regression ser ut så här.

På motsvarande sätt, vad är lambda vid linjär regression?

När vi har hög examen linjär polynom som används för att passa en uppsättning punkter i en linjär regression för att förhindra överanpassning använder vi regularisering och vi inkluderar en lambda parameter i kostnadsfunktionen. Detta lambda används sedan för att uppdatera theta-parametrarna i algoritmen för gradientnedstigning.

För det andra, vad är syftet med regularisering? Regularisering är en teknik som används för att ställa in fungera genom att lägga till ytterligare en strafftid i felet fungera . Tilläggstermen styr det alltför fluktuerande fungera så att koefficienterna inte tar extrema värden.

Varför behöver vi på så sätt reglera oss i regression?

Målet med regularisering är att undvika övermontering, med andra ord vi försöker undvika modeller som passar extremt bra till träningsdatan (data som används för att bygga modellen), men som passar dåligt till testdata (data som används för att testa hur bra modellen är). Detta är känt som övermontering.

Vad betyder regularisering?

Inom matematik, statistik och datavetenskap, särskilt inom maskininlärning och omvända problem, regularisering är processen att lägga till information för att lösa ett illa ställt problem eller för att förhindra överanpassning. Regularisering gäller objektiva funktioner i illa ställda optimeringsproblem.

Rekommenderad:

Är linjär sökning detsamma som sekventiell sökning?

Klass: Sökalgoritm

Vad är definitionen av en linjär blockkod?

'En linjär blockkod är en blockkod där exklusiva-eller av två kodord resulterar i ett annat kodord

Varför anses Premiere Pro vara en icke-linjär redigerare?

Icke-linjär videoredigering, å andra sidan, låter dig gå direkt till bildrutan där du vill utföra redigeringar. Premiere Pro är en icke-linjär redigerare. Premiere Pro ändrar dock inte den ursprungliga filmen, varför vi säger att den är oförstörande

Vad är linjär blockkod?

I kodningsteorin är en linjär kod en felkorrigerande kod för vilken en linjär kombination av kodord också är ett kodord. Kodorden i en linjär blockkod är block av symboler som är kodade med fler symboler än det ursprungliga värdet som ska skickas

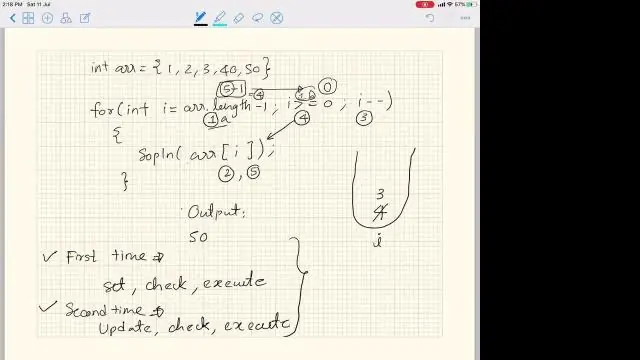

Vad är linjär datastruktur i datastruktur?

Linjär datastruktur: Datastruktur där dataelement är ordnade sekventiellt eller linjärt där elementen är kopplade till dess föregående och nästa angränsande i vad som kallas en linjär datastruktur. I linjär datastruktur är en nivå involverad. Därför kan vi korsa alla element i en enda körning