Innehållsförteckning:

- Författare Lynn Donovan [email protected].

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

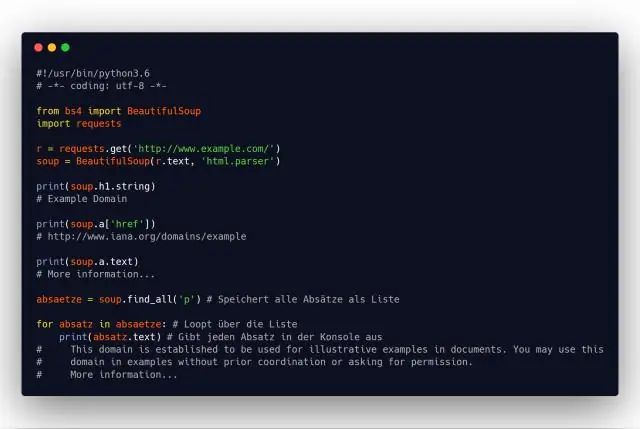

För att extrahera data med webbskrapning med python måste du följa dessa grundläggande steg:

- Hitta webbadressen som du vill skrapa.

- Inspekterar sidan.

- Hitta data du vill extrahera.

- Skriv koden.

- Kör koden och extrahera data .

- Förvara data i önskat format.

Med tanke på detta, vad är webbskrapning i Python?

Web skrapning använder sig av Pytonorm . Web skrapning är en term som används för att beskriva användningen av ett program eller en algoritm för att extrahera och bearbeta stora mängder data från webb . Oavsett om du är en datavetare, ingenjör eller någon som analyserar stora mängder datamängder, kan du skrapa data från webb är en användbar färdighet att ha

Kan Excel dessutom hämta data från en webbplats? Du burk enkelt importera en tabell över data från en webbsida in i Excel , och uppdatera tabellen regelbundet med live data . Öppna ett kalkylblad i Excel . Från Data menyn välj antingen Importera extern Data eller Skaffa extern Data . Gå in i URL av webbsida varifrån du vill importera data och klicka på Gå.

Med avseende på detta, hur skrapar du en webbplats med Python och BeautifulSoup?

Först måste vi importera alla bibliotek som vi ska använda. Deklarera sedan en variabel för sidans url. Använd sedan Pytonorm urllib2 för att få HTML-sidan för webbadressen deklarerad. Till sist, analysera sidan till Vacker soppa format så vi kan använda Vacker soppa att jobba på det.

Är det lagligt att skrapa webbplatsdata?

Ofta, webbplatser kommer att tillåta tredje part skrapning . Till exempel de flesta webbplatser ge Google uttryckligt eller underförstått tillstånd att indexera deras webb sidor. Fastän skrapning är allestädes närvarande, det är inte tydligt Rättslig . En mängd olika lagar kan gälla för obehöriga skrapning , inklusive avtal, upphovsrätt och lagar om intrång i lösöre.

Rekommenderad:

Vilka fakta samlar Ansible på?

Fakta som samlas in i Ansible, fakta är inget annat än information som vi får genom att prata med fjärrsystemet. Ansible använder inställningsmodulen för att upptäcka denna information automatiskt. Ibland krävs denna information i Playbook eftersom detta är dynamisk information som hämtas från fjärrsystem

Hur stoppar jag webbplatser från att öppna oönskade Windows-flikar?

Google Chrome 5.0 Öppna webbläsaren, välj skiftnyckelikonen och välj sedan "Alternativ". Välj fliken "Under huven" och välj sedan "Innehållsinställningar". Klicka på fliken "Popups", välj "Tillåt inte att några webbplatser visar popup-fönster (rekommenderas)" och välj sedan "Stäng". Mozilla: Popup-blockerare

Hur samlar vi in information?

Sätt att samla in information stämmer/räknas. Säkra vägar till skolstudentreseformulär. Undersökningar. Enkäter eller frågeformulär används ofta vid utvärdering. Observationer och revisioner. Observation av en skola: Elevens ankomst eller avresa. Intervjuer. Befintliga datakällor. Utvärderingsstandarder. Arbeta med skolor

Varför samlar deltan elefanter?

Många Deltas samlar på elefanter eftersom en av våra grundande sorors älskade att göra just det. När hon gick bort skänktes hennes samling av elefanter till Grand Chapter av Delta Sigma Theta Sorority, Inc., där de finns utställda i våra arkiv. Elefanten symboliserar styrka och beslutsamhet

Vad samlar GC på python?

Gc – Garbage Collector. gc avslöjar den underliggande minneshanteringsmekanismen för Python, den automatiska sopsamlaren. Modulen innehåller funktioner för att kontrollera hur kollektorn fungerar och för att undersöka de objekt som är kända för systemet, antingen i väntan på insamling eller fastnat i referenscykler och inte kan frigöras