Innehållsförteckning:

- Författare Lynn Donovan [email protected].

- Public 2024-01-18 08:29.

- Senast ändrad 2025-01-22 17:41.

Jag följer dessa steg för att skapa en DataFrame från listan med tupler:

- Skapa a lista av tuplar. Varje tupel innehåller namnet på en person med ålder.

- Skapa en RDD från lista ovan.

- Konvertera varje tuppel till en rad.

- Skapa a DataFrame genom att applicera createDataFrame på RDD med hjälp av sqlContext.

Med tanke på detta, hur konverterar du en DataFrame till en lista i Python?

- Steg 1: Konvertera Dataframe till en kapslad Numpy-array med DataFrame.to_numpy() dvs.

- Steg 2: Konvertera 2D Numpy-array till en lista med listor.

- Steg 1: Transponera dataramen för att konvertera rader som kolumner och kolumner som rader.

- Steg 2: Konvertera Dataframe till en kapslad Numpy-array med DataFrame.to_numpy()

Dessutom, vad är en spark DataFrame? A Spark DataFrame är en distribuerad samling av data organiserad i namngivna kolumner som tillhandahåller operationer för att filtrera, gruppera eller beräkna aggregat, och som kan användas med Gnista SQL. Dataramar kan konstrueras från strukturerade datafiler, befintliga RDD:er, tabeller i Hive eller externa databaser.

Vet också, vad är PySpark SQL?

Spark SQL är en Gnista modul för strukturerad databehandling. Den tillhandahåller en programmeringsabstraktion som kallas DataFrames och kan också fungera som en distribuerad SQL frågemotor. Det gör att omodifierade Hadoop Hive-frågor kan köras upp till 100 gånger snabbare på befintliga distributioner och data.

Är spark DataFrames oföränderliga?

I Gnista du kan inte - Dataramar är oföränderlig . Du bör använda.

Rekommenderad:

Hur gör jag ett API-anrop från Excel?

Anropa API från Excel Gå till fliken Data i menyfliksområdet och välj Från webben under avsnittet Hämta och transformera data. Detta kan också hittas under Hämta data i menyn Från andra källor. Vi behöver bara använda den grundläggande frågan så att du kan lägga in din URL i fältet och trycka på OK-knappen

Hur gör man en att göra-lista i JavaScript?

Hur man bygger en Todo List-app med JavaScript-förutsättningar. Denna handledning förutsätter en grundläggande kunskap om JavaScript. Komma igång. Att göra-listan-appen vi kommer att bygga kommer att vara ganska grundläggande. Lägg till en uppgift. Det första vi behöver göra är att ställa in en array för att hålla våra att göra-lista. Gör att göra-objekten. Markera en uppgift som "klar" Ta bort att göra-objekt. Lägg till en tom statusprompt

Hur gör jag en mp3 från en DVD?

Konvertera DVD-filer offline Installera och starta programmet. Tryck på den vänstra Lägg till-knappen på toppmenyn för att importera DVD-filen. Vidarebefordra till ljudalternativet och välj "MP3"-format. Ställ in utdatamappen och klicka sedan på "Konvertera"-knappen. Vänta ett tag så kommer MP3:n att sparas på din PC

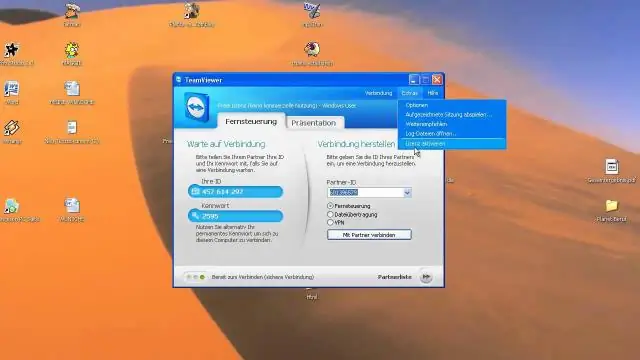

Hur gör jag för fjärrskrivbord till min hemdator från jobbet?

Konfigurera arbetsdator Klicka på "Start"-knappen och högerklicka på "Dator" och välj sedan "Egenskaper". Klicka på menyn "Fjärrinställningar" och välj fliken "Fjärr". Kontrollera alternativet 'Tillåt anslutningar av fjärrhjälp till den här datorn'. Klicka på "Välj användare" och "Lägg till" i dialogrutan Användare av fjärrskrivbord

Hur gör jag en p12-fil från CER?

Processen STEG 1: Skapa en ".certSigningRequest" (CSR)-fil. Öppna Keychain Access på din Mac (finns i Applications/Utilities) STEG 2: Skapa filen ".cer" i ditt iOS-utvecklarkonto. Logga in på https://developer.apple.com. STEG 3: Installera. cer och generera