- Författare Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

I lekmannatermer, den själv - uppmärksamhet mekanism låter ingångarna interagera med varandra (“ själv ”) och ta reda på vem de ska betala mer uppmärksamhet till (“ uppmärksamhet ”). Utgångarna är aggregat av dessa interaktioner och uppmärksamhet poäng.

Dessutom, vad är självuppmärksamhet?

Själv - uppmärksamhet , ibland kallad intra- uppmärksamhet är en uppmärksamhet mekanism som relaterar olika positioner av en enda sekvens för att beräkna en representation av sekvensen.

Dessutom, vad är självuppmärksamhet i djupinlärning? Låt oss först definiera vad " själv - Uppmärksamhet " är. Cheng et al, i sin artikel som heter "Long Short-Term Memory-Networks for Maskin Läsning”, definieras själv - Uppmärksamhet som mekanismen för att relatera olika positioner i en enda sekvens eller mening för att få en mer levande representation.

Angående detta, vad är uppmärksamhetsmekanismen?

Uppmärksamhetsmekanism tillåter avkodaren att ta hand om olika delar av källsatsen vid varje steg av utdatagenereringen. Istället för att koda inmatningssekvensen till en enda fast kontextvektor låter vi modellen lära sig hur man genererar en kontextvektor för varje utmatningstidssteg.

Vad är en uppmärksamhetsbaserad modell?

Uppmärksamhet - baserade modeller tillhör en klass av modeller vanligen kallad sekvens-till-sekvens modeller . Syftet med dessa modeller , som namnet antyder, för att producera en utgångssekvens givet en ingångssekvens som i allmänhet är av olika längd.

Rekommenderad:

Hur fungerar Spring AOP proxy?

AOP-proxy: ett objekt som skapats av AOP-ramverket för att implementera aspektkontrakten (ge råd om metodexekveringar och så vidare). I Spring Framework kommer en AOP-proxy att vara en JDK-dynamisk proxy eller en CGLIB-proxy. Vävning: länka aspekter med andra applikationstyper eller objekt för att skapa ett rekommenderat objekt

Hur fungerar en spegel-tv?

En spegel-TV består av speciellt halvtransparent spegelglas med en LCD-TV bakom den spegelvända ytan. Spegeln är noggrant polariserad så att en bild kan överföras genom spegeln, så att när TV:n är avstängd ser enheten ut som en spegel

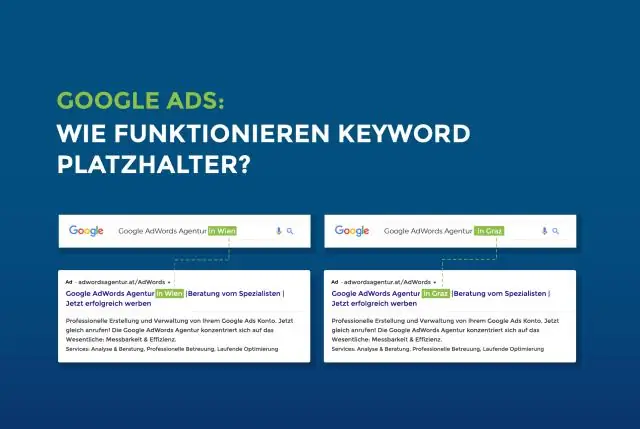

Hur fungerar platshållare?

Platshållarattributet anger en kort ledtråd som beskriver det förväntade värdet för ett inmatningsfält (t.ex. ett exempelvärde eller en kort beskrivning av det förväntade formatet). Obs! Platshållarattributet fungerar med följande inmatningstyper: text, sökning, url, tel, e-post och lösenord

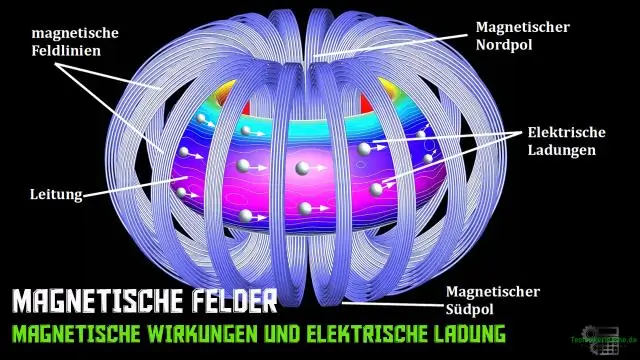

Hur fungerar magnetiska säkerhetsremsor?

Remsan är fodrad magnetiskt material med en måttlig magnetisk "hårdhet". Detektering sker när man känner av övertoner och signaler som genereras av materialets magnetiska respons under lågfrekventa magnetfält. När det ferromagnetiska materialet magnetiseras tvingar det den amorfa metallremsan till mättnad

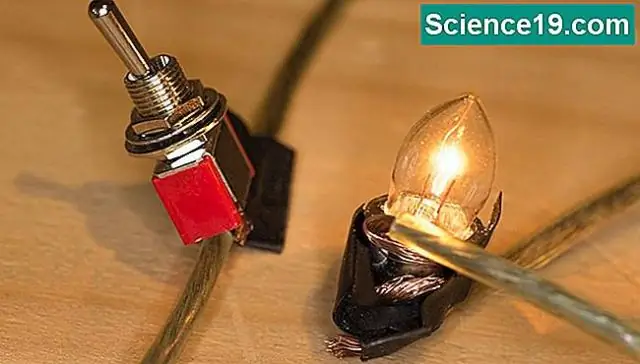

Hur fungerar lampor som du rör för att tända?

Det betyder att om en krets försökte ladda lampan med elektroner, skulle det ta ett visst antal för att "fylla den". När du rör vid lampan ökar din kropp sin kapacitet. Det krävs fler elektroner för att fylla dig och lampan, och kretsen upptäcker den skillnaden