- Författare Lynn Donovan [email protected].

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

Hadoop är ett ramverk med öppen källkod som tillhandahåller bearbetning av stora data uppsättningar över kluster av datorer med enkla programmeringsmodeller. Hadoop är designad för att skala upp från enstaka servrar till tusentals maskiner.

Häri, vad är Hadoop i dataanalys?

Hadoop . Hadoop är en uppsättning öppen källkodsprogram skrivna i Java som kan användas för att utföra operationer på en stor mängd data . Hadoop är ett skalbart, distribuerat och feltolerant ekosystem. Hadoop MapReduce = används för att ladda data från en databas, formatera den och utföra en kvantitativ analys på det.

varför används Hadoop för big data-analys? Hadoop är ett ramverk för öppen källkod för lagring data och köra applikationer på kluster av råvaruhårdvara. Det ger massiv förvaring för alla typer av data , enorm processorkraft och förmågan att hantera praktiskt taget obegränsade samtidiga uppgifter eller jobb.

Vad är då Apache Hadoops funktioner i dataanalys?

Apache Hadoop programvara är ett kraftfullt ramverk för att möjliggöra distribuerad behandling av stora datamängder över flera datorkluster. Den är utformad för att skala upp från enstaka servrar till tusentals servermaskiner. Detta mål anses tillhandahålla lokal beräkning och lagring av varje server.

Är Hadoop en datavetenskap?

Svaret på denna fråga är ett stort JA! Datavetenskap är ett stort fält. Huvudfunktionen hos Hadoop är förvaring av Big Data . Det tillåter också användarna att lagra alla former av data , det vill säga båda strukturerade data och ostrukturerad data . Hadoop tillhandahåller även moduler som Pig och Hive för analys i stor skala data.

Rekommenderad:

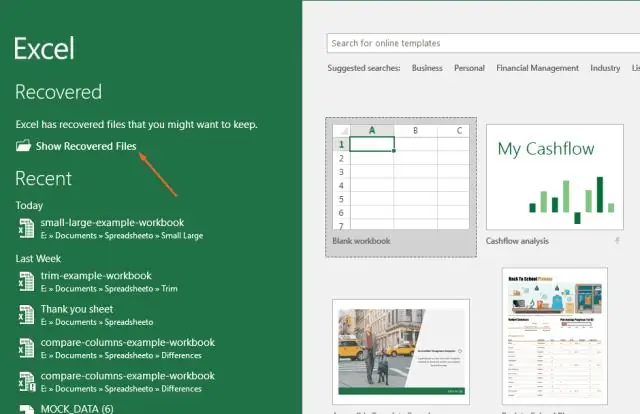

Hur öppnar jag dataanalys i Excel 2007?

Excel 2007: Data Analysis-tillägget ska visas till höger på Data-menyn som DataAnalysis. Klicka på Microsoft Office-knappen och klicka sedan på Excel-alternativ. Klicka på Tillägg och välj sedan Excel-tillägg i rutan Hantera. Klicka på Gå

Hur gör man dataanalys i R?

I det här inlägget kommer vi att granska några funktioner som leder oss till analysen av det första fallet. Steg 1 – Första inställningen till data. Steg 2 – Analysera kategoriska variabler. Steg 3 – Analysera numeriska variabler. Steg 4 – Analysera numeriskt och kategoriskt på samma gång

Hur får du dataanalys på Excel 2011 för Mac?

I rutan Tillgängliga tillägg markerar du kryssrutan AnalysisToolPak - VBA. Obs: Analysis ToolPak är inte tillgängligt för Excel för Mac 2011. Ladda Analysis ToolPak i Excel Klicka på fliken Arkiv, klicka på Alternativ och klicka sedan på Add-Inscategory. I rutan Hantera väljer du Excel-tillägg och klickar sedan på Gå

Hur använder företag dataanalys i sin verksamhet?

Big data-analys innebär att man undersöker stora mängder data. Detta görs för att avslöja de dolda mönstren, sambanden och även för att ge insikter för att fatta korrekta affärsbeslut. I grund och botten vill företag vara mer objektiva och datadrivna, och därför anammar de kraften i data och teknik

Hur används dataanalys inom sport?

Det finns två nyckelaspekter av sportanalys - analytics på fältet och utanför fältet. Analyser på fältet handlar om att förbättra prestandan på fältet för lag och spelare. Off-field analytics använder i huvudsak data för att hjälpa rättighetsinnehavare att fatta beslut som skulle leda till högre tillväxt och ökad lönsamhet