- Författare Lynn Donovan [email protected].

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

Starta Gnista Bemästra på flera noder och se till att dessa noder har samma Djurskötare konfiguration för ZooKeeper URL och katalog.

Information.

| Systemegenskap | Menande |

|---|---|

| gnista .deploy. djurparksskötare .dir | Katalogen i ZooKeeper för att lagra återställningstillstånd (standard: / gnista ). Detta kan vara valfritt |

Därav, kan du köra spark lokalt?

Spark burk vara springa med den inbyggda fristående klusterschemaläggaren i lokal läge. Detta innebär att alla Gnista processer är springa inom samma JVM-effektivt, en enda, flertrådad instans av Gnista.

För det andra, kan Spark användas utan Hadoop? Enligt Gnista dokumentation, Spark burk springa utan Hadoop . Du kan köra det som ett fristående läge utan någon resursförvaltare. Men om du vill köra i multi-nod-inställning behöver du en resurshanterare som YARN eller Mesos och ett distribuerat filsystem som HDFS , S3 etc. Ja, gnista burk springa utan hadoop.

Att veta är också varför ZooKeeper används i Hadoop?

Djurskötare i Hadoop kan ses som ett centraliserat arkiv där distribuerade applikationer kan lägga data och få ut data ur den. Det är Begagnade att hålla det distribuerade systemet fungerande tillsammans som en enda enhet, med hjälp av dess mål för synkronisering, serialisering och koordinering.

Hur fungerar spark fristående?

Fristående mode är en enkel klusterhanterare inbyggd med Gnista . Det gör det enkelt att sätta upp ett kluster som Gnista själv hanterar och kan köras på Linux, Windows eller Mac OSX. Ofta är det det enklaste sättet att springa Gnista applikation i en klustrad miljö. Lär dig hur du installerar Apache Spark På Fristående Läge.

Rekommenderad:

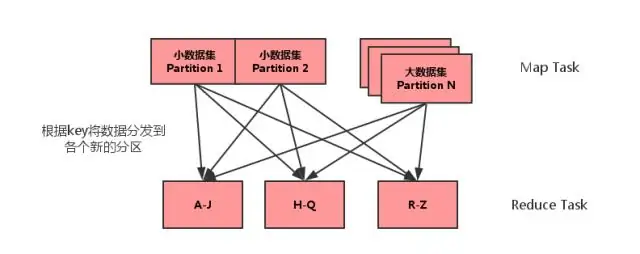

Vad är MAP side join in spark?

Map side join är en process där sammanfogningar mellan två tabeller utförs i kartfasen utan inblandning av reduceringsfasen. Map-side Joins gör att en tabell kan laddas in i minnet, vilket säkerställer en mycket snabb sammanfogningsoperation, utförd helt inom en mapper och det också utan att behöva använda både kartan och minska faserna

Vad är nytt i Spark?

Förutom buggfixar finns det två nya funktioner i Spark 2.4: SPARK-22239 Användardefinierade fönsterfunktioner med Pandas UDF. SPARK-22274 Användardefinierade aggregeringsfunktioner med pandas udf. Vi tror att dessa nya funktioner kommer att ytterligare förbättra adoptionen av Pandas UDF, och vi kommer att fortsätta att förbättra Pandas UDF i nästa versioner

Vilken version av Python använder spark?

Spark körs på Java 8+, Python 2.7+/3.4+ och R 3.1+. För Scala API, Spark 2.3. 0 använder Scala 2.11. Du måste använda en kompatibel Scala-version (2.11

Hur ställer jag in spark-instant messenger?

Installationsguide för Spark IM Ladda ner Spark från Spark IM-webbplatsen. Installera och starta Spark på din dator. Ange ditt Olark-användarnamn i det översta fältet, ditt lösenord i mittfältet och "@olark.com" för domänen. Tryck på enter och då loggas du in på Spark IM! Glad chatt

Hur startar jag min spark History-server?

För att aktivera Spark-historikservern: Skapa en katalog för händelseloggar i DSEFS-filsystemet: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events. När händelseloggning är aktiverad är standardbeteendet att alla loggar sparas, vilket gör att lagringen växer över tiden