Innehållsförteckning:

- Författare Lynn Donovan [email protected].

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

Konfigurationsfilerna som behöver uppdateras för att ställa in ett fullt distribuerat läge för Hadoop är:

- Hadoop-env.sh.

- Kärnplats. xml.

- Hdfs-sida. xml.

- Kartlagd plats. xml.

- Mästare.

- Slavar.

Dessutom, vilka är de viktiga konfigurationsfilerna i Hadoop?

Hadoop-konfigurationen drivs av två typer av viktiga konfigurationsfiler:

- Skrivskyddad standardkonfiguration - src/core/core-default. xml, src/hdfs/hdfs-default. xml och src/mapred/mapred-default. xml.

- Platsspecifik konfiguration - conf/core-site. xml, conf/hdfs-webbplats. xml och conf/mapred-site. xml.

På liknande sätt, vilka av följande innehåller konfigurationer för HDFS-demoner? xml innehåller konfiguration inställningar för HDFS-demoner (dvs. NameNode, DataNode, Secondary NameNode). Det inkluderar också replikeringsfaktorn och blockstorleken för HDFS.

vad är konfigurationsfiler i Hadoop?

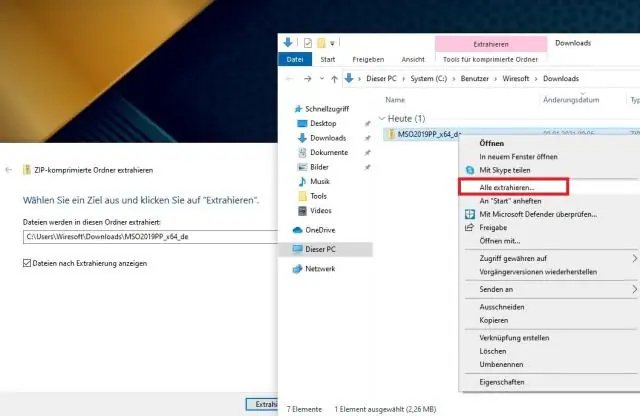

Konfigurationsfiler är de filer som finns i den extraherade tjäran. gz fil i etc/ hadoop / katalog. Allt Konfigurationsfiler i Hadoop listas nedan, 1) HADOOP -ENV.sh->>Det specificerar miljövariablerna som påverkar JDK som används av Hadoop Daemon (bin/ hadoop ).

Vilka filer hanterar små filproblem i Hadoop?

1) HAR ( Hadoop Arkiv) Filer har introducerats till hantera problem med små filer . HAR har infört ett lager ovanpå HDFS , som tillhandahåller gränssnitt för fil åtkomst. Använder sig av Hadoop arkivkommando, HAR filer skapas, som kör en MapReduce jobb att packa filer arkiveras i mindre antal HDFS-filer.

Rekommenderad:

Vilken typ av algoritmer kräver att avsändare och mottagare utbyter en hemlig nyckel som används för att säkerställa konfidentialitet för meddelanden?

Vilken typ av algoritmer kräver att avsändare och mottagare utbyter en hemlig nyckel som används för att säkerställa konfidentialitet för meddelanden? Förklaring: Symmetriska algoritmer använder samma nyckel, en hemlig nyckel, för att kryptera och dekryptera data. Denna nyckel måste delas i förväg innan kommunikation kan ske

Varför rekommenderas det att ställa in viktiga uppdateringar så att de installeras automatiskt?

Programuppdateringar är viktiga eftersom de ofta innehåller kritiska korrigeringar till säkerhetshål. Faktum är att många av de mer skadliga attackerna med skadlig programvara drar fördel av sårbarheter i mjukvara i vanliga applikationer, som operativsystem och webbläsare

Vad är det totala antalet kommunikationslinjer som behövs för ett fullt anslutet punkt till punkt-nätverk med fem datorer och sex datorer?

Antalet kommunikationslinjer som krävs för ett fullt anslutet punkt-till-punkt-nätverk med åtta datorer är tjugoåtta. Ett helt anslutet nio datornätverk kräver trettiosex linjer. Ett fullt anslutet tio-datornätverk kräver fyrtiofem linjer

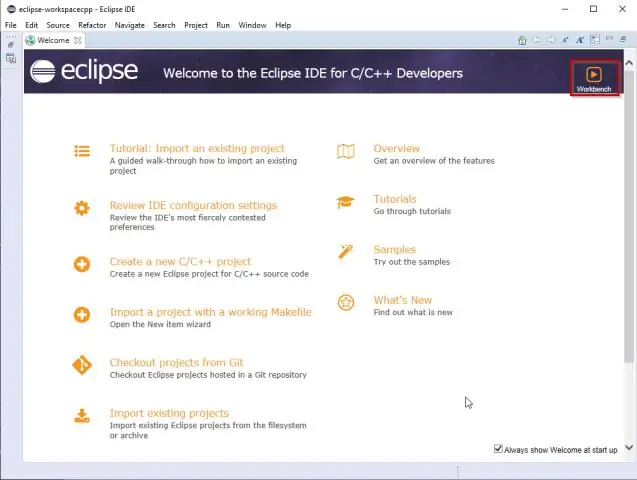

Behöver vi ställa in miljövariabler för Eclipse?

Om du vill ha dessa miljövariabler tillgängliga i Eclipse måste du lägga dem i /etc/environment. Du kan också definiera en miljövariabel som endast är synlig inom Eclipse. Gå till Kör -> Kör konfigurationer och välj fliken "Miljö"

Vilket kommando använder du för att ställa in ett Git-förråd inuti din mapp?

Starta ett nytt git-förråd Skapa en katalog som innehåller projektet. Gå in i den nya katalogen. Skriv git init. Skriv lite kod. Skriv git add för att lägga till filerna (se sidan för vanlig användning). Skriv git commit