- Författare Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

Datalokalisering i Hadoop . Ta exempel på Wordcount, där de flesta av orden har upprepats i 5 Lacs eller fler gånger. I det fallet efter Mapper-fasen kommer varje mappar-utgång att ha ord i intervallet 5 Lacs. Denna fullständiga process för att lagra Mapper-utdata till LFS kallas som Datalokalisering.

Med tanke på detta, vad är datalokalisering i Hadoop?

Konceptet av Data ort i Hadoop-data ort i MapReduce hänvisar till förmågan att flytta beräkningen nära där den faktiska data ligger på noden, istället för att flytta sig stort data till beräkning. Detta minimerar nätverksstockning och ökar systemets totala genomströmning.

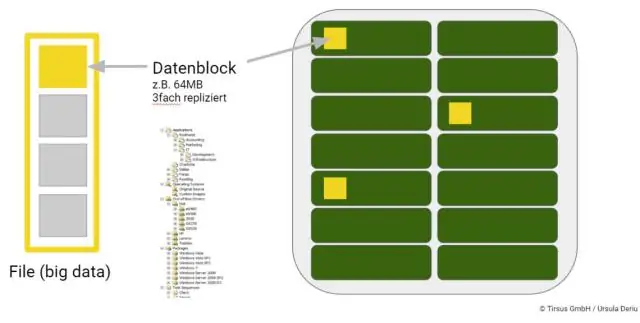

Dessutom, hur lagras big data? De flesta associerar automatiskt HDFS, eller Hadoop Distributed File System, med Hadoop data lager. HDFS lagrar information i kluster som består av mindre block. Dessa block är lagrat fysiskt på plats lagring enheter, såsom interna diskenheter.

Bara så, hur lagras data i Hadoop?

På en Hadoop kluster, den data inom HDFS och MapReduce-systemet finns på varje maskin i klustret. Data är lagrat i data block på DataNodes. HDFS replikerar dessa data block, vanligtvis 128 MB i storlek, och distribuerar dem så att de replikeras inom flera noder över klustret.

Hur lagras filer i HDFS?

HDFS avslöjar en fil systemnamnutrymme och tillåter användardata att vara lagrat i filer . Internt, a fil är uppdelad i ett eller flera block och dessa block är lagrat i en uppsättning DataNodes. NameNode körs fil systemnamnutrymmesoperationer som att öppna, stänga och byta namn filer och kataloger.

Rekommenderad:

Hur uppnås konsensus i Blockchain?

Vad är en konsensusmekanism? En konsensusmekanism är en feltolerant mekanism som används i dator- och blockkedjesystem för att uppnå den nödvändiga överenskommelsen om ett enda datavärde eller ett enda tillstånd i nätverket bland distribuerade processer eller system med flera agenter, till exempel med kryptovalutor

Hur fungerar HBase i Hadoop?

HBase är en datamodell som liknar Googles stora tabell som är utformad för att ge slumpmässig tillgång till stora volymer strukturerad eller ostrukturerad data. HBase är en viktig komponent i Hadoop-ekosystemet som utnyttjar funktionen för feltolerans i HDFS. HBase ger läs- eller skrivåtkomst i realtid till data i HDFS

Hur uppnås multithreading i Python?

Med trådning uppnås samtidighet genom att använda flera trådar, men på grund av GIL kan endast en tråd köras åt gången. Vid multibearbetning delas den ursprungliga processen in i flera underordnade processer som går förbi GIL. Varje underordnad process kommer att ha en kopia av hela programmets minne

Hur blir jag en Hadoop-administratör?

Steg för att bli en Hadoop-administratör Förstå grunderna och egenskaperna hos Big Data och använd dem för att hjälpa organisationer att hantera Big Data. Arbeta med Hadoop-klienter och webbgränssnitt. Använd klusterplanering och verktyg för datainmatning i Hadoop-kluster. Använd Hadoop-komponenter inom Hadoop-ekosystemet

Hur skapar jag en mapp i Hadoop filsystem?

Skapa en katalog i HDFS. Användning: $ hdfs dfs -mkdir Lista innehållet i en katalog i HDFS. Ladda upp en fil till HDFS. Ladda ner en fil från HDFS. Kontrollera ett filtillstånd i HDFS. Se innehållet i en fil i HDFS. Kopiera en fil från källa till destination i HDFS. Kopiera en fil från/till det lokala filsystemet till HDFS