Innehållsförteckning:

- Författare Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:53.

- Senast ändrad 2025-01-22 17:41.

Samla (Åtgärd) - Returnera alla element i datamängden som en array i drivrutinsprogrammet. Detta är vanligtvis användbart efter ett filter eller annan operation som returnerar en tillräckligt liten delmängd av data.

På det här sättet, vad är PySpark?

PySpark Programmering. PySpark är ett samarbete mellan Apache Spark och Python. Apache Spark är ett ramverk för klusterberäkningar med öppen källkod, byggt kring hastighet, användarvänlighet och strömningsanalys, medan Python är ett generellt programmeringsspråk på hög nivå.

Dessutom, vad är karta i PySpark? Gnista Karta Omvandling. A Karta är en transformationsverksamhet i Apache Spark. Den gäller för varje element i RDD och den returnerar resultatet som ny RDD. Karta omvandlar en RDD med längden N till en annan RDD med längden N. Ingångs- och utmatnings-RDD:erna kommer vanligtvis att ha samma antal poster.

På det här sättet, vad är SparkContext i PySpark?

PySpark - SparkContext . Annonser. SparkContext är ingångspunkten till någon gnista funktionalitet. När vi kör någon Gnista applikation startar ett drivrutinsprogram som har huvudfunktionen och din SparkContext initieras här. Drivrutinsprogrammet kör sedan operationerna inuti executorerna på arbetarnoder.

Hur kontrollerar jag PySpark-versionen?

2 svar

- Öppna Spark Shell Terminal och ange kommandot.

- sc.version Eller spark-submit --version.

- Det enklaste sättet är att bara starta "spark-shell" på kommandoraden. Den kommer att visa.

- nuvarande aktiva version av Spark.

Rekommenderad:

Vad är w3c vad är Whatwg?

Web Hypertext Application Technology Working Group (WHATWG) är en grupp människor som är intresserade av att utveckla HTML och relaterade teknologier. WHATWG grundades av personer från Apple Inc., Mozilla Foundation och Opera Software, ledande webbläsarleverantörer, 2004

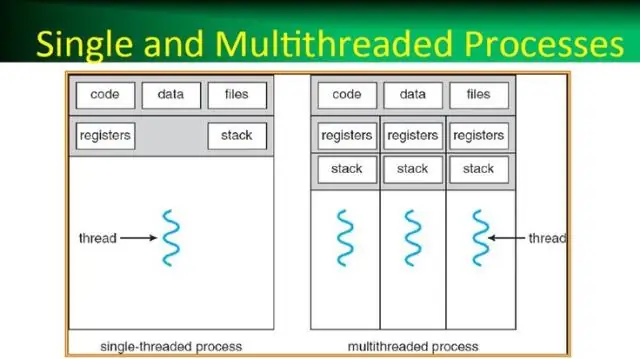

Vad är en process i ett operativsystem vad är en tråd i ett operativsystem?

En process, i de enklaste termerna, är ett exekveringsprogram. En eller flera trådar körs inom ramen för processen. En tråd är den grundläggande enhet till vilken operativsystemet allokerar processortid. Trådpoolen används främst för att minska antalet applikationstrådar och tillhandahålla hantering av arbetstrådarna

Vad är en persondator Vad är förkortningen?

PC - Detta är förkortningen för persondator

Hur gör jag en PySpark DataFrame från en lista?

Jag följer dessa steg för att skapa en DataFrame från listan med tupler: Skapa en lista med tupler. Varje tuppel innehåller namnet på en person med ålder. Skapa en RDD från listan ovan. Konvertera varje tupel till en rad. Skapa en DataFrame genom att applicera createDataFrame på RDD med hjälp av sqlContext

Vad är rad i PySpark?

En rad i SchemaRDD. Fälten i den kan nås som attribut. Rad kan användas för att skapa ett radobjekt genom att använda namngivna argument, fälten kommer att sorteras efter namn